Предупреждение об изощренных телефонных мошенничествах с использованием технологии имитации голоса

Вы когда-нибудь задумывались, что ваш голос могут скопировать и использовать для обмана? Это не научная фантастика, а тревожная реальность. Узнайте об этом изощрённом способе мошенничества и о том, как защитить себя.

В последнее время был выпущен ряд предупреждений об угрозах безопасности, создаваемых искусственным интеллектом (ИИ): от вредоносного кода, способного похитить данные для входа в систему, до сложных атак, нацеленных на мобильных пользователей.

.jpg)

Однако наибольшую обеспокоенность сейчас вызывают атаки методом глубокого фишинга, нацеленные на пользователей смартфонов, несмотря на активные усилия Google, Apple и других технологических компаний по усилению защиты.

На самом деле, эти атаки настолько изощрены, что даже эксперты по безопасности, включая ФБР, предупреждают общественность: «Немедленно повесьте трубку и установите секретный код для своей защиты». Вот что нужно знать, чтобы не стать жертвой.

ФБР и эксперты предупреждают: Deepfake нацелен на пользователей телефонов

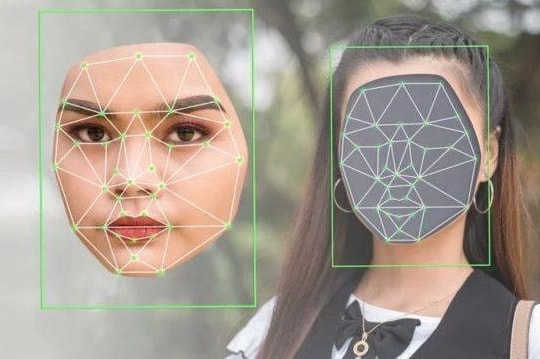

Когда большинство людей думают о дипфейках, они представляют себе видео с подменой лиц, но угроза гораздо шире. Одним из самых опасных видов мошенничества сегодня является подделка голоса с помощью искусственного интеллекта (ИИ), технологии, которая становится всё более популярной и доступной.

Эксперт по кибербезопасности охранной компании NordVPN (Литва) Адрианус Варменховен подчеркнул, что киберпреступники используют технологию копирования голоса для осуществления телефонных мошенничеств.

.jpg)

«Мошенники используют эту технологию, чтобы звонить родственникам жертвы, выдавать себя за них и создавать чрезвычайную ситуацию, чтобы вымогать деньги», — пояснил г-н Варменховен.

Согласно недавнему отчету, только в США за последние 12 месяцев жертвами телефонного мошенничества стали более 50 миллионов человек, при этом средний убыток на человека составил 452 доллара.

«Дипфейки полностью меняют способ работы мошеннических звонков, делая их обнаружение более сложным, чем когда-либо», — предупредил г-н Варменховен.

Технология искусственного интеллекта: новый инструмент для киберпреступников

Европол также предупредил о росте числа атак с использованием искусственного интеллекта, предположив, что киберпреступники становятся «высокотехнологичными преступными предприятиями».

По словам Катрин Де Болле, исполнительного директора Европола, эти организации становятся всё более адаптивными и опасными благодаря технологиям искусственного интеллекта. В последнем докладе Европола утверждается: «ИИ полностью меняет ландшафт организованной преступности, помогая им автоматизировать и расширять свою преступную деятельность, делая её более масштабной, более изощрённой и более сложной для обнаружения».

Эван Дорнбуш, бывший эксперт по кибербезопасности Агентства национальной безопасности США (АНБ), заявил: «Главная ценность ИИ заключается не в большей креативности или интеллекте, а в способности действовать быстрее. Злоумышленники могут создавать вдвое более убедительные сценарии фишинга за меньшее время и постоянно совершенствовать их для максимальной эффективности».

Чтобы бороться с этими преступлениями, Де Болле подчеркнул: «Нам необходимо разрушить их финансовые системы и цепочки поставок, а также использовать технологии, чтобы не допустить дальнейшего усиления преступных сетей».

ФБР рассказывает пользователям телефонов, как защитить себя от мошенничества с использованием дипфейков

В связи с растущей распространенностью подделок голоса ФБР выпустило предупреждение с конкретными рекомендациями по минимизации рисков:

- Немедленно повесьте трубку, если вам позвонит кто-то, представившийся членом семьи или другом, и попросивший срочно перевести деньги.

- Проверьте личность звонящего, связавшись с ним напрямую или через другого родственника.

- Создайте секретный код, который будете знать только вы и ваши близкие друзья, чтобы использовать его в случае подтверждения личности.

- Ограничьте распространение своего голоса в социальных сетях, поскольку это крупнейший источник данных, который ИИ может собирать и создавать имитации голоса.

Эксперт по кибербезопасности Варменховен подчеркнул: «Социальные сети — это огромный архив публичной информации, которым могут воспользоваться киберпреступники. Будьте осторожны с тем, чем делитесь, чтобы не стать жертвой дипфейков и других форм мошенничества».

Короче говоря, технологии искусственного интеллекта (ИИ) приносят множество преимуществ, но также открывают двери беспрецедентным рискам. По мере того, как дипфейки становятся всё более изощрёнными, важно повышать осведомлённость и заблаговременно защищать себя и свои семьи от потенциальных угроз.

Будьте бдительны и примите защитные меры уже сейчас, чтобы не стать следующей жертвой мошенников, использующих высокие технологии.

.jpg)