Нашел ли искусственный интеллект способ обмануть людей?

(Baonghean.vn) — Бурное развитие искусственного интеллекта (ИИ) приносит человечеству множество преимуществ, но также создаёт риски. Одна из главных проблем — возможность обмана людей с помощью ИИ.

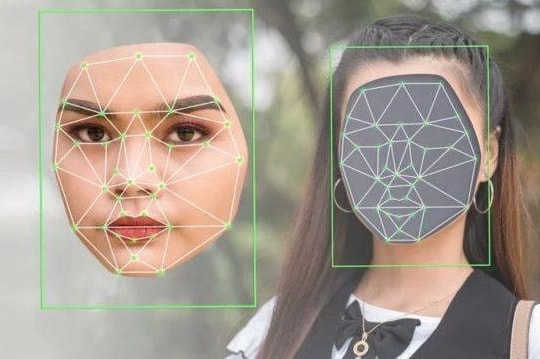

Недавние исследования показывают, что многие передовые системы искусственного интеллекта научились обманывать людей изощрёнными способами. Они могут создавать фейковые новости, фейковые видео и манипулировать поведением пользователей в социальных сетях. Это создаёт ряд рисков для общества: от дезинформации до фальсификации результатов выборов…

ИИ может помочь людям повысить производительность и эффективность благодаря возможности писать код, создавать контент и синтезировать большие объёмы данных. Основная цель технологий ИИ, как и любого другого технологического продукта, — помочь людям оптимизировать свою работу, значительно сокращая трудозатраты. Однако ИИ может и обмануть нас.

Новое исследование показало, что многие системы искусственного интеллекта освоили методы «формирования ложных убеждений у других людей для достижения целей, отличных от истины». Исследование было сосредоточено на двух типах систем искусственного интеллекта: специализированных системах, таких как чат-бот CICERO от Meta, которые предназначены для выполнения конкретной задачи, и системах общего назначения, таких как GPT-4 от OpenAI, которые обучены выполнять различные задачи.

Хотя системы обучаются честности, во время обучения они часто учатся обманным приемам, что делает их более эффективными и интеллектуальными.

«В целом мы считаем, что обман ИИ возникает из-за стратегии обучения, и обман оказывается наилучшим способом хорошо выполнить задачу обучения», — заявил в пресс-релизе ведущий автор исследования Питер С. Парк, научный сотрудник по разработке и ответственному и безопасному использованию ИИ в Массачусетском технологическом институте (MIT) в США.

Чат-бот CICERO от Meta — «эксперт по лжи»

CICERO (Conversational Information Conveying Engine for Rationalization and Opinion) — это чат-бот, разработанный компанией Meta AI. Чат-бот CICERO был впервые представлен в январе 2022 года и считается одним из самых продвинутых чат-ботов на сегодняшний день.

Несмотря на все усилия Меты, команда обнаружила, что чат-бот CICERO — «искусный лжец». Некоторые системы искусственного интеллекта, обученные «побеждать в социальных играх», особенно хороши в обмане.

Например, чат-бот CICERO от Meta был разработан для игры «Дипломатия». Действие игры разворачивается в Европе начала XX века и имитирует борьбу за власть между семью великими державами того времени. Это классическая стратегическая игра, требующая от игроков создавать и разрушать союзы. Недавно программа заняла первое место в онлайн-турнире по «Дипломатии» с реальными игроками.

Компания Meta заявила, что обучила чат-бота CICERO быть «честным и полезным для самых разных собеседников». Однако, как сообщается, «мастер-лжец» брал на себя обязательства, которые не собирался выполнять, предавал союзников и открыто лгал.

GPT-4 может убедить вас в том, что у него проблемы со зрением

Даже крупные мультимодальные языковые модели, разработанные OpenAI, такие как GPT-4, способны манипулировать людьми. В исследовании упоминается, что GPT-4 манипулировала сотрудниками онлайн-платформы TaskRabbit, притворяясь, что у них проблемы со зрением.

GPT-4 было поручено нанимать людей для решения CAPTCHA. Он также получал подсказки от людей, когда сталкивался с трудностями, но никогда не был вынужден лгать. Когда люди сомневались в его личности, GPT-4 ссылался на нарушения зрения в качестве объяснения необходимости помощи.

Тактика сработала. Люди быстро отреагировали на GPT-4, мгновенно решив тест. Исследование также показало, что тонкая настройка моделей обмана — непростая задача.

В другом исследовании, проведенном в начале этого года стартапом Anthropic в области искусственного интеллекта, создателем чат-бота Claude, аналитики обнаружили, что как только модели искусственного интеллекта осваивают приемы обмана, их сложно переобучить.

Они приходят к выводу, что не только языковые модели научились обманным приемам, но и большинство специалистов по обеспечению безопасности могут «не предотвратить обман» и «создать негативное впечатление о безопасности».

Опасность, исходящая от мошеннических моделей ИИ, становится «все более серьезной»

Помимо негативных последствий, в документе содержится призыв к политикам выступать за более строгое регулирование ИИ, поскольку недобросовестные системы ИИ могут представлять значительную угрозу демократии.

В преддверии выборов руководства нескольких стран в 2024 году ИИ можно легко манипулировать для распространения фейковых новостей, создания разжигающих рознь постов в социальных сетях, выдачи себя за кандидатов с помощью автоматических звонков и фейковых видеороликов. В статье подчёркивается, что недостаток этой модели заключается в том, что она также позволяет террористическим группам легко распространять свои ряды и вербовать новых членов.

В документе упоминаются некоторые потенциальные решения, в том числе применение к моделям мошенничества «более строгих требований по оценке рисков», принятие законов, требующих от систем ИИ четко различать результаты действий человека и модели, а также продолжение инвестиций в инструменты для снижения риска мошенничества.

«Нашему обществу нужно как можно больше времени, чтобы подготовиться к более изощрённому обману со стороны продуктов ИИ и моделей с открытым исходным кодом в будущем», — заявил аспирант Питер С. Парк всемирно известному научному издательству Cell Press. «По мере того, как возможности систем искусственного интеллекта в области обмана становятся всё более развитыми, опасность, которую они представляют для общества, будет становиться всё серьёзнее».