什么是 ChatGPT:面向非技术人员的简单解释

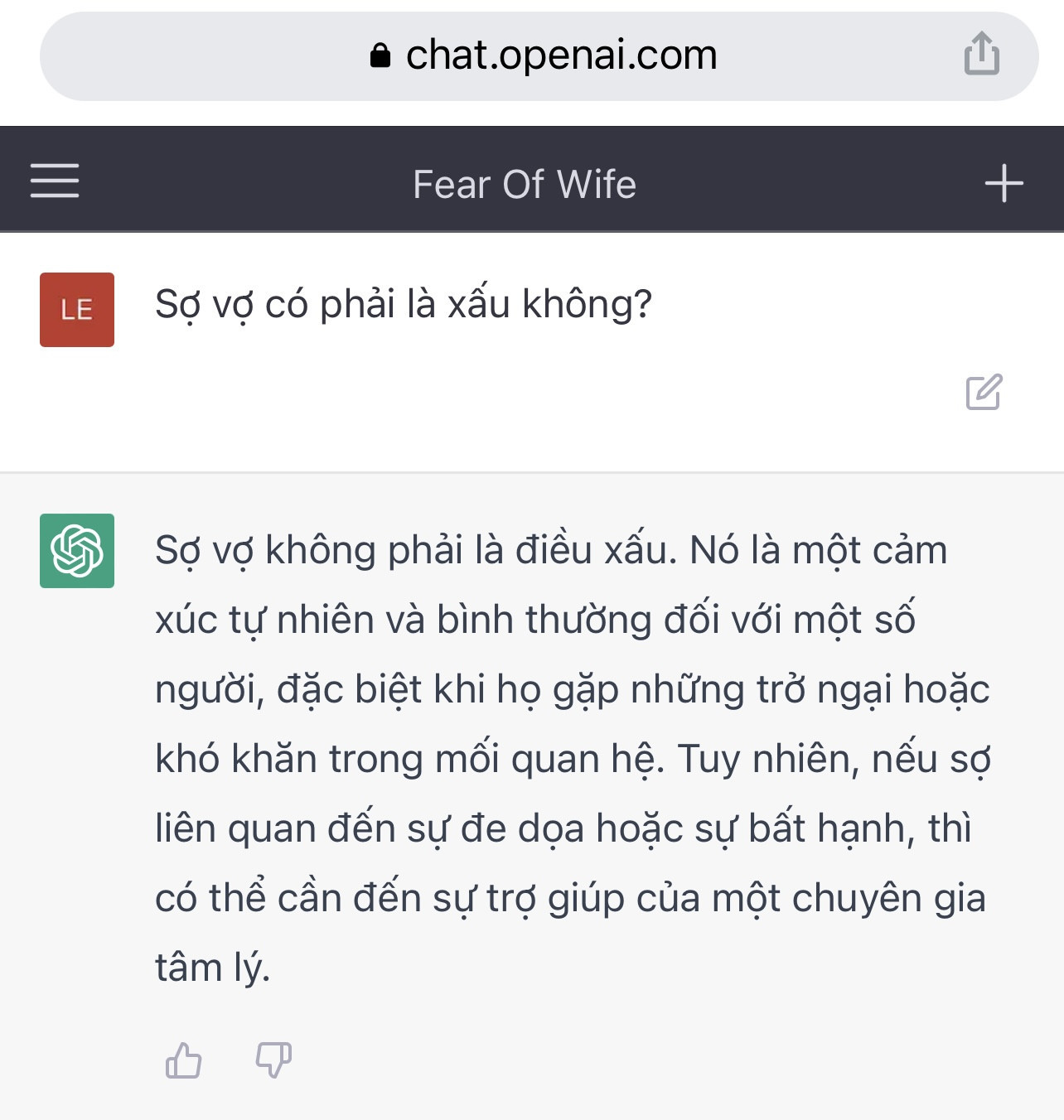

对于普通用户来说,ChatGPT 只是一个聊天网站,可以与虚拟机器人讨论各种话题。

ChatGPT 目前是社交网络上最热门的关键词之一。然而,并非所有人都能清楚地理解这款人工智能程序的本质。以下,越南网报想向读者推荐一篇由安全专家阮红福撰写的关于 ChatGPT 的文章,旨在帮助那些不了解该技术的人轻松理解。

ChatGPT简单理解

对于普通用户来说,ChatGPT 只是一个聊天网站,可以与虚拟机器人讨论各种话题。

这款机器人是由埃隆·马斯克于2015年创立的OpenAI公司创建的,其最初的使命是“防止人工智能的危险”。

ChatGPT 是如何创建的?

ChatGPT 是一款人工智能计算机程序。技术上,人们通常称之为 Model AI,越南语中是“人工智能数据模型”,但实际上它仍然是在计算机上运行的数字数据,所以称其为程序也并无不妥。

模型AI这个词由两部分组成:模型(数据模型)和AI(人工智能)。字面意思是智能源于数据,意思是数据多了,智能就产生了。

创建AI模型的过程是由以下步骤组成的过程:数据收集、数据选择、用于训练的数据标记和训练。

教人工智能基本上很容易,就像这样的对话:

问题:你叫什么名字?

回答:我的名字是 ChatGPT

问:什么是 VietnamNet?

答:VietNamNet是越南的一份电子报纸。

然后我们教会AI记住这些信息(训练),然后将AI记忆的大脑保存为一个AI模型(模型检查点)。之后使用时,将包含上述信息的记忆大脑加载到计算机中(推理),只需要问出相应的问题,AI就会记住已经教过的知识,并“一字不差”地回答。

事实上,过去几十年,AI 已经专注于许多具体的工作,例如:支持飞机制造的 AI、模拟战斗的 AI、游戏中的 AI……但几乎没有大公司在语言领域投资 AI。直到 2017 年,才出现了一项技术突破,使得 AI 训练,尤其是语言 AI 的效率显著提升。

语言,特别是文字,是创造人类文明的成果。人类的知识蕴含在文字之中。理解语言(文字)就是理解人类的知识。这是语言人工智能诞生的核心点。在2017年之前,人类很难让计算机理解一个有意义的句子的含义。

那么 2017 年会发生什么?

2017年8月,谷歌的科学家,特别是谷歌大脑(自2011年以来一直是谷歌的人工智能研究部门)发明了一种名为Transformer的算法(该算法的名称与电影界的著名电影《机器人大战》非常相似)。

Transformer 算法是一项突破,具体来说是语言 AI 训练领域的一项突破。在此算法出现之前,人类如果想教 AI,就必须创建一个包含问答对(标签数据)的训练数据集,正如上文所述。而机器实际上只能记住问答对,却无法“理解”句子的含义,这在死记硬背和理解之间有着巨大的差异。

更容易理解的是,2017年之后,我们只需要输入尽可能多的文本数据,计算机就会自动理解我们输入的内容是什么意思,而不需要我们告诉它含义。

引自谷歌Transformer公告文件:“有了Transformer,计算机就可以看到人类看到的相同模式。”

谷歌慷慨地将Transformer算法的详细文档公开发布,供所有人访问。同时,它还提供了该算法的开源权利。因此,整个人工智能科学界都受益于谷歌的这项发明。其中包括OpenAI,这家成立于2015年的公司,直到2017年之后才取得了突出的成就。

谷歌宣布Transformer之后,几个月后,基于这一新算法的首批语言AI就纷纷诞生。2018年1月,OpenAI发布了第一个基于Transformer的AI——GPT-1,并且很快投入应用,比谷歌自己还快。

GPT 代表 Generative Pre-trained Transformer,意思是“生成式预训练 Transformer 程序”

这个人工智能 GPT 的主要目的是“生成单词”。具体来说,你可以和它玩一个单词联想游戏,你写一个句子,它会读出这个句子,然后根据它存储在记忆中的知识,“生成单词”来延续你写的句子。

例如:

您输入的是:越南是

ChatGPT:越南是一个位于东南亚的国家……

这就是看似“神奇”的事情:你和 ChatGPT 聊一句话,它就会回复你一句话。其实它不是在回答你,而是在通过“生成单词”进行单词连接,从而延续你在聊天中输入的句子的含义。

|

GPT-1 是 ChatGPT 的第一代。这个 GPT-1 是一个相当小的 AI,无论是规模还是复杂度都比较小。 |

在语言人工智能领域,人们用一个叫做“超参数”的单位来衡量复杂性——它对应于人工智能的“智能”水平。这个概念可以粗略地解释为,这个人工智能能够理解用于教授它的所有文本的多少层含义。

为了得到这样的答案,OpenAI 的科学家收集了大量人类书面文本。

为了训练这个人工智能 GPT,OpenAI 的科学家收集了大量人类书写的文本,主要来自维基百科、百科全书以及主流和公共报纸,文本量大约有数百 GB,文档数量达数亿。收集完成后,他们清理并筛选内容。然后,他们将这些文档交给人工智能阅读,让它反复阅读,每次阅读时,它都能理解这些词语背后的含义,阅读次数越多,含义的层次就越多。

人工智能经过训练可以达到对人类书面语言的深度理解水平,这导致了一个非常严重的问题,迄今为止还没有人工智能科学家能够解决这个问题。

计算“真”或“假”。AI无法理解什么是“真”或“假”。

人工智能能够理解一句话的多层含义,但却无法“理解其含义的对错”。正因为对错是相对的,所以对人类而言,它是脆弱且充满争议的,甚至会引发人类之间的争斗。

此外,OpenAI 的科学家为训练 AI 而收集的大量文本数据,并非全都是“正确”的,也并非全都包含着按照人类社会标准“正确”的信息,因为数据量太大,超出了他们的选择能力。

例如,他们可能会收集声称地球是圆的文本,也可能收集声称地球是平的文本。数据包含真实和虚假的信息。当人工智能反复阅读这些文本以寻找层层含义时,它也会发现“真”与“假”的含义,但人工智能没有意识去识别哪些含义(哪些信息是真的,哪些信息是假的)。人工智能只是简单地记住了所有内容。当之后被问到时,它只会根据记忆中的这些信息来回答,而不会区分是非对错。

谷歌、Facebook、IBM、微软等公司曾多次宣布其语言人工智能在回答人类输入问题方面取得突破,但很快又删除了这些人工智能。你可以在互联网上搜索各大报纸的相关文章。主要是因为这些人工智能在回答某些问题时,会带有不可接受的“错误”含义,而这些含义与当前的人类社会标准相悖,例如对性别的尊重、对宗教的尊重、对种族的尊重、对已发生事件的准确性、对人类公认的真理的尊重等等。

大公司都坚持信息准确性的标准,他们评估AI无法解决正确与错误认知的问题,所以最好不要上市。

|

GPT-3 也一样,它也会创造出违反人类“对错”标准的段落,甚至错到让人无法接受的地步。 |

正当 GPT-3 走向普及之际,新冠疫情在全球爆发。从 2020 年中期开始,疫情形势愈发紧张,疫情信息完全淹没了 GPT-3 的信息。

AI GPT-3 和 OpenAI 直到 2022 年底才被公众遗忘。OpenAI 决定做一个营销计划,看看是否能重新激起人们对语言 AI 的兴趣?

因此,他们将 AI GPT-3 修改为 ChatGPT,使其更易于使用,ChatGPT 不再以网站的形式出现,人们在其中输入单词、编辑参数,然后返回一段连贯的单词,而是以聊天程序的形式出现,带有聊天框以输入问题,AI ChatGPT 用该问题玩生成单词连接单词的游戏,但是以答案的形式出现。

总结一下ChatGPT在过去一个月的成功公式:一个经过足够深度训练,能够生成有意义、足够让读者信服的句子的语言AI+一家AI科技公司的不道德本质+合适的UI/UX(聊天)=ChatGPT。

人工智能可以看到一句话的多层含义,但无法“理解这个含义是对是错”。

(专家阮红福)