5 conseils pour vous aider à détecter les faux contenus générés par l'IA

Les vidéos générées par l'IA ont connu une explosion ces derniers temps, brouillant la frontière entre le vrai et le faux. Pour éviter de vous faire avoir, voici quelques conseils simples pour vous aider à distinguer les contenus fiables.

Avec les progrès fulgurants de l'IA, il devient de plus en plus difficile de distinguer le vrai du faux en ligne. Outre les images fixes, les vidéos générées par l'IA connaissent également une explosion grâce à des outils comme Sora d'OpenAI et Veo de Google. Dans ce contexte, faire la part des choses entre le réel et la fiction représente un véritable défi.

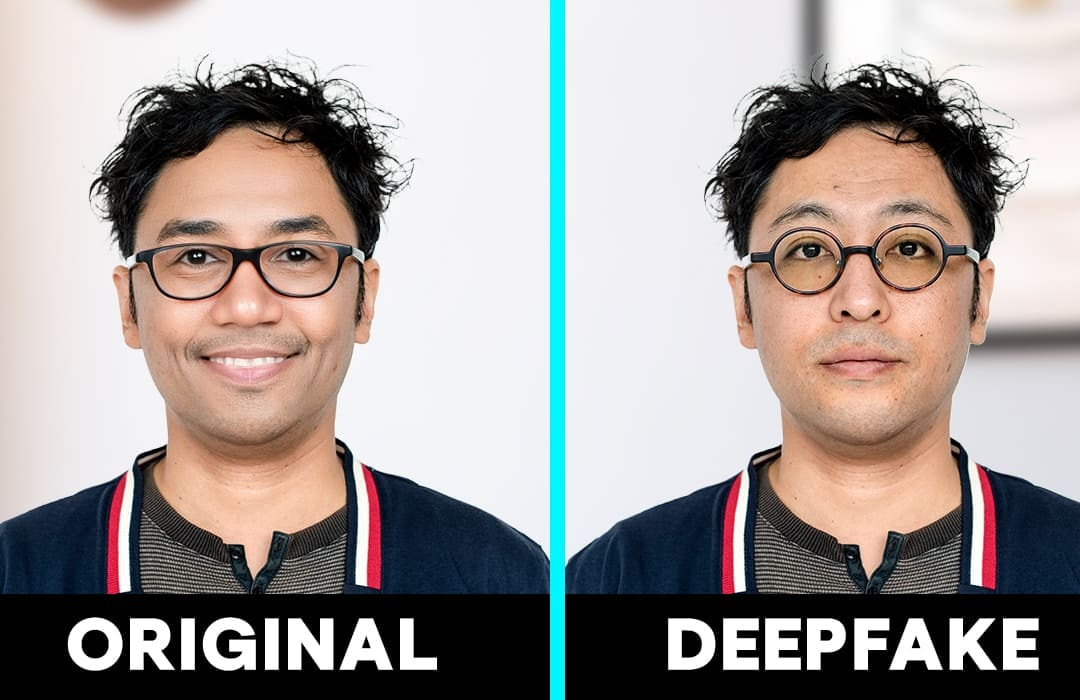

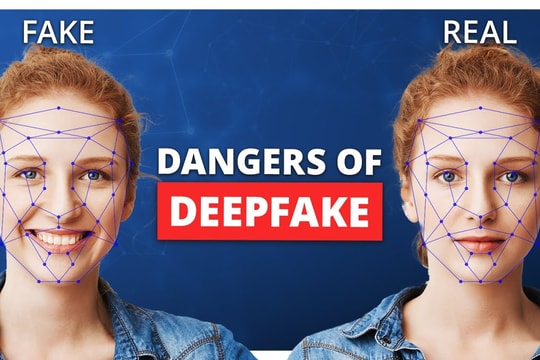

Actuellement, les logiciels de détection de vidéos générées par IA sont limités, à l'exception de ceux conçus pour détecter les deepfakes. Nous sommes donc largement contraints de nous fier à notre sens de l'observation et à notre intuition. Voici quelques indices clés permettant de reconnaître une vidéo truquée générée par IA.

1. Les fausses vidéos générées par l'IA ne respectent souvent pas les lois de la physique.

L'un des moyens les plus simples de repérer une vidéo truquée générée par IA est de vérifier si elle respecte les lois de la physique. Dans la réalité, les lunettes ne lévitent pas, les liquides ne traversent pas les objets solides, mais avec Sora d'OpenAI, ces absurdités sont possibles.

Même OpenAI admet que Sora ne simule pas avec précision des interactions basiques comme le bris de verre. Lors du visionnage de vidéos, portez une attention particulière à la fois à l'action principale et aux détails de l'arrière-plan afin de repérer toute anomalie.

Écoutez aussi votre intuition. Si quelque chose vous paraît « bizarre », même si vous n’arrivez pas à l’exprimer précisément, cela pourrait indiquer que la vidéo a été générée par une IA.

2. Observez attentivement les réactions du monde qui vous entoure.

La réaction du monde environnant est également un indice important pour reconnaître les vidéos d'IA. Dans la réalité, croquer dans une pomme devrait la faire disparaître, mais dans le monde de Sora, ce n'est pas forcément le cas.

OpenAI reconnaît que des interactions comme manger ne produisent pas toujours les mêmes modifications de l'état de l'objet. Par conséquent, lorsqu'on regarde une vidéo, il faut prêter attention non seulement à l'action, mais aussi à la réaction qui en découle, c'est-à-dire aux conséquences physiques, aux changements survenus dans l'environnement ou sur l'objet.

Par exemple, une personne marche sur du sable mais ne laisse aucune nouvelle empreinte, ou de l'eau est renversée sur le sol mais celui-ci reste sec et sans tache.

3. Avez-vous remarqué quelque chose d'inhabituel dans la vidéo ?

Vous est-il déjà arrivé de regarder une vidéo et d'avoir l'impression que « quelque chose cloche », sans pouvoir immédiatement mettre le doigt dessus ? C'est une expérience courante lorsqu'on regarde des vidéos générées par l'IA.

Les anomalies peuvent être évidentes, mais parfois, c'est juste un détail fugace et vague qui vous fait vous arrêter et vous demander : « Quel moment m'a mis mal à l'aise ? » Ce sont ces petits détails qui révèlent souvent les incohérences dans la logique de fonctionnement du monde virtuel que construit l'IA.

Par exemple, dans une vidéo, on voit une main peindre minutieusement une branche de cerisier en fleurs. Les coups de pinceau se succèdent, la peinture apparaît progressivement, mais étrangement, la couleur des coups de pinceau change soudainement, alors même que le pinceau n'a jamais été trempé à nouveau dans la palette. C'est un exemple typique d'« erreurs subtiles » que les spectateurs doivent être attentifs pour remarquer.

4. Essayez la « reconstitution inversée » en recréant la vidéo.

Une autre approche pour aider les utilisateurs à évaluer l'authenticité des vidéos générées par l'IA consiste à tenter une « remontée en arrière » en recréant la vidéo.

Les adeptes du générateur d'images en texte Midjourney expérimentent une approche de « traçage inversé ». Ils observent attentivement les vidéos générées par Sora, puis réécrivent des descriptions proches des séquences originales et les intègrent à l'outil Midjourney pour créer des images fixes.

Les résultats montrent que, dans de nombreux cas, les vidéos de Sora ne sont que des « photos animées de Midjourney ». Cela démontre le lien étroit entre les modèles de génération d'images et de vidéos, et soulève des questions quant au véritable niveau de créativité de Sora.

Si vous souhaitez solliciter davantage vos sens lors de l'analyse d'une vidéo, vous pouvez essayer une méthode similaire. Imaginez la description qui correspond à la scène et utilisez un outil de conversion texte-image pour évaluer la ressemblance.

Ensuite, effectuez une recherche Google pour vérifier si la vidéo provient de données publiques. Cette méthode n'est pas infaillible, mais elle constitue un bon point de départ pour déterminer s'il s'agit d'une vidéo authentique ou d'une création de l'IA.

5. Restez toujours vigilant et mettez à jour vos connaissances technologiques.

La technologie d'IA permettant de créer des vidéos à partir de texte n'en est qu'à ses débuts, mais son développement est extrêmement rapide. En très peu de temps, les modèles d'IA peuvent créer des vidéos très détaillées, si réalistes qu'il est difficile pour les spectateurs de distinguer le vrai du faux.

Cela signifie que le risque d'être trompé par du contenu généré par l'IA augmente. La meilleure façon d'éviter d'en être victime est d'apprendre à évoluer avec la technologie, c'est-à-dire de mettre à jour constamment ses connaissances, de se tenir informé des nouveaux outils et de perfectionner ses compétences en analyse d'images et de son.

.jpg)