Avertissement concernant les escroqueries téléphoniques sophistiquées utilisant une technologie d'imitation de la voix

Avez-vous déjà imaginé que votre voix puisse être copiée et utilisée pour escroquer d'autres personnes ? Ce n'est pas de la science-fiction, mais une réalité alarmante. Découvrez cette arnaque sophistiquée et comment vous en protéger.

Ces derniers temps, une série d’avertissements concernant les risques de sécurité causés par l’intelligence artificielle (IA) ont été émis, allant du code malveillant capable de voler des informations de connexion à des attaques sophistiquées ciblant les utilisateurs mobiles.

.jpg)

La plus grande préoccupation à l’heure actuelle concerne toutefois les attaques de phishing de type deepfake ciblant les utilisateurs de smartphones, malgré les efforts agressifs de Google, Apple et d’autres entreprises technologiques pour renforcer la protection.

En fait, ces attaques sont si sophistiquées que même les experts en sécurité, dont le FBI, ont mis en garde le public : « Raccrochez immédiatement et créez un code secret pour vous protéger. » Voici ce que vous devez savoir pour éviter d'en être victime.

Le FBI et les experts mettent en garde : le deepfake cible les utilisateurs de téléphones

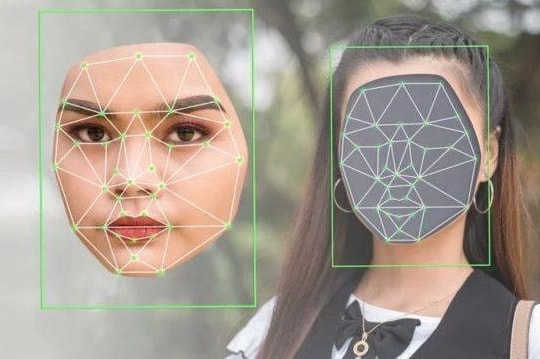

Quand on pense aux deepfakes, on pense généralement à des vidéos de substitution de visages, mais la menace est bien plus vaste. L'une des arnaques les plus dangereuses aujourd'hui est la simulation de voix par IA, une technologie de plus en plus populaire et accessible.

Adrianus Warmenhoven, expert en cybersécurité chez la société de sécurité NordVPN (Lituanie), a souligné que les cybercriminels profitent de la technologie de copie vocale pour mener des escroqueries téléphoniques.

.jpg)

« Les fraudeurs utilisent cette technologie pour appeler les proches de la victime, se faire passer pour eux et créer une situation d'urgence pour extorquer de l'argent », a expliqué M. Warmenhoven.

Un rapport récent a révélé qu'aux États-Unis seulement, plus de 50 millions de personnes ont été victimes d'escroqueries téléphoniques au cours des 12 derniers mois, avec une perte moyenne de 452 dollars par personne.

« Les deepfakes changent complètement la façon dont fonctionnent les appels frauduleux, les rendant plus difficiles que jamais à détecter », a averti M. Warmenhoven.

Technologie de l'IA : un nouvel outil pour les cybercriminels

Europol a également mis en garde contre la montée des attaques utilisant l'IA, suggérant que les cybercriminels deviennent des « entreprises criminelles de haute technologie ».

Selon Catherine De Bolle, directrice exécutive d'Europol, ces organisations deviennent plus adaptatives et dangereuses grâce à l'IA. Le dernier rapport d'Europol affirme : « L'IA transforme profondément le paysage du crime organisé, l'aidant à automatiser et à étendre ses activités criminelles à plus grande échelle, de manière plus sophistiquée et plus difficile à détecter. »

Evan Dornbush, ancien expert en cybersécurité à l'Agence nationale de sécurité américaine (NSA), a déclaré : « Le plus grand atout de l'IA n'est pas d'être plus créative ou plus intelligente, mais de pouvoir agir plus rapidement. Les attaquants peuvent créer des scénarios d'hameçonnage deux fois plus convaincants en moins de temps et les affiner en permanence pour une efficacité maximale. »

Pour lutter contre ces crimes, a souligné De Bolle : « Nous devons perturber leurs systèmes financiers et leurs chaînes d'approvisionnement, et devancer la technologie pour empêcher les réseaux criminels de devenir encore plus forts. »

Le FBI explique aux utilisateurs de téléphones comment se protéger des arnaques deepfake

À la lumière de la prévalence croissante des deepfakes vocaux, le FBI a émis un avertissement, avec des recommandations spécifiques pour minimiser les risques :

- Raccrochez immédiatement si vous recevez un appel d'une personne prétendant être un membre de votre famille ou un ami et demandant un transfert d'argent urgent.

- Vérifiez l'identité de l'appelant en le contactant directement ou par l'intermédiaire d'un autre proche.

- Configurez un code secret que seuls vous et vos amis proches connaissent, à utiliser en cas de vérification d'identité.

- Limitez le partage de votre voix sur les réseaux sociaux, car il s'agit de la plus grande source de données permettant à l'IA de collecter et de créer des voix deepfake.

L'expert en cybersécurité Warmenhoven a souligné : « Les réseaux sociaux constituent une immense archive de voix publiques que les cybercriminels peuvent exploiter. Soyez prudents quant à ce que vous partagez pour éviter d'être la cible de deepfakes et d'autres formes de fraude. »

En résumé, l'IA offre de nombreux avantages, mais elle ouvre également la voie à des risques sans précédent. Face à la sophistication croissante des deepfakes, il est important que chacun se sensibilise et se protège proactivement, ainsi que sa famille, contre les menaces potentielles.

Restez vigilant et prenez des mesures de protection dès maintenant pour éviter de devenir la prochaine victime des escrocs de haute technologie.

.jpg)