Une vidéo réalisée par une IA montrant une fausse inondation à Gyeongbokgung provoque l'indignation et soulève des inquiétudes quant à la manipulation de l'information.

L'essor des technologies de génération vidéo par intelligence artificielle représente un défi majeur pour la lutte contre la désinformation en Corée du Sud, comme en témoigne la diffusion virale d'une vidéo simulant un palais de Gyeongbokgung inondé.

Une vidéo d'intelligence artificielle montrant l'inondation du palais de Gyeongbokgung choque l'opinion publique

Une vidéo créée à l'aide de l'intelligence artificielle (IA) simulant la scène du palais de Gyeongbokgung à Séoul submergé par l'eau fait sensation dans la communauté en ligne coréenne.

La vidéo, publiée par la chaîne YouTube « Golpadak », s’ouvre sur un homme en imperméable jaune, debout devant le palais, qui déclare : « Il pleut des cordes… Gyeongbokgung est complètement inondé. » S’ensuivent des images de personnes écopant l’eau avec des seaux et même d’un phoque glissant sur le terrain du palais.

Malgré ses détails absurdes, la vidéo a tout de même convaincu beaucoup de gens de son authenticité car elle coïncidait avec la période où Séoul subissait des pluies record.

Il a été confirmé par la suite que la vidéo avait été réalisée avec Veo 3 de Google, un logiciel permettant de créer des images et des dialogues réalistes. L'indignation a été générale, et nombreux sont ceux qui estiment que le créateur devrait être sanctionné pour diffusion délibérée de fausses informations.

Les préoccupations liées aux deepfakes et le défi du contrôle de l'information

L'incident de la fausse vidéo sur les inondations de Gyeongbokgung n'est pas un cas isolé. Des dizaines de vidéos similaires, truquées et présentant de fausses inondations, sont apparues sur YouTube, suscitant de vives réactions de la part des médias et des experts. Ces derniers alertent sur le fait que le public est de plus en plus dupé par des contenus générés par intelligence artificielle, même lorsque les détails de ces vidéos sont pour le moins absurdes.

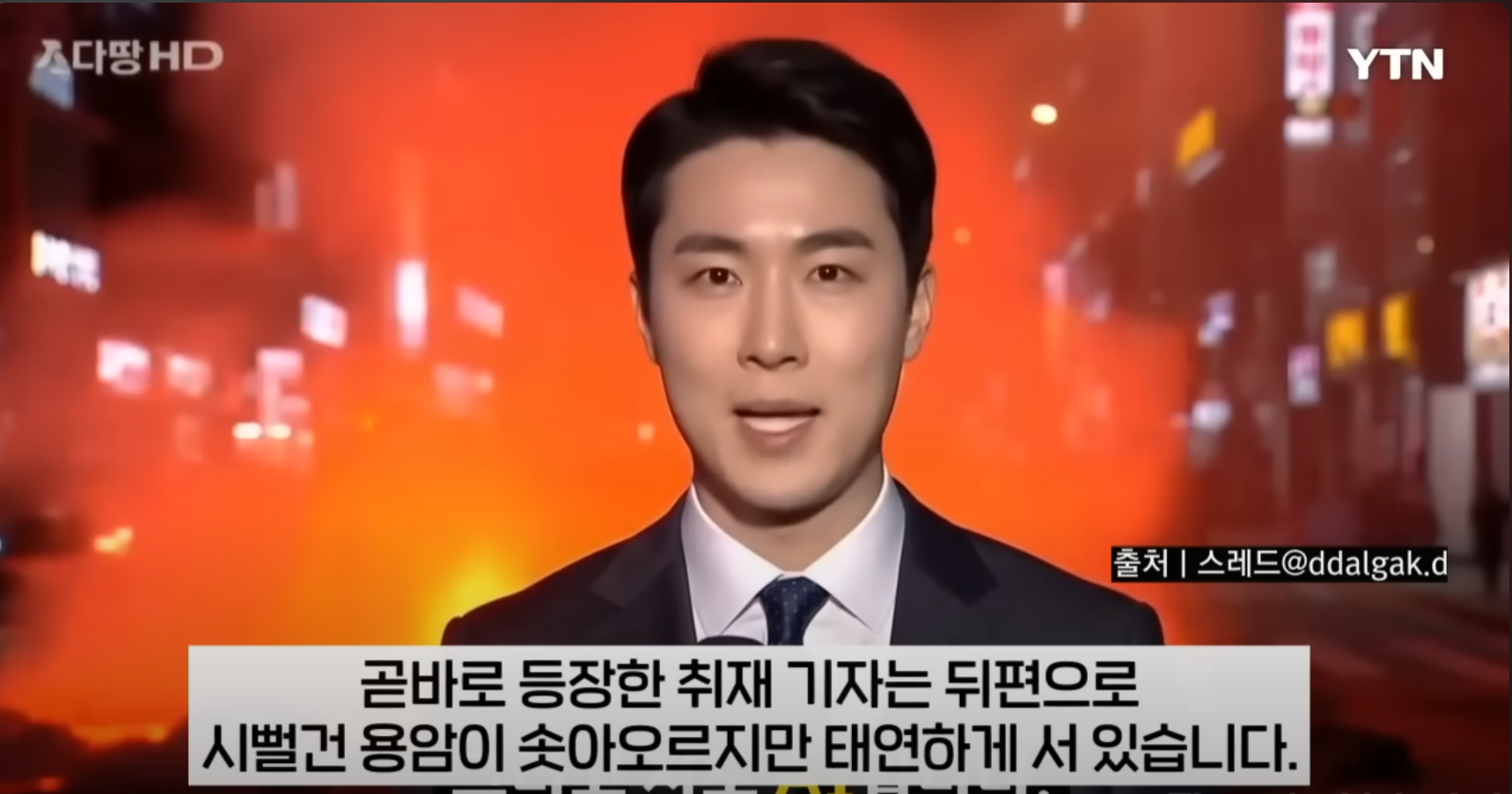

Auparavant, une autre fausse vidéo simulant une coulée de lave au cœur de Séoul avait également semé la confusion parmi les internautes. Son créateur, le youtubeur « Ddalgak », a déclaré que son but était de satiriser la crédulité des utilisateurs d'Internet face aux contenus en ligne. Il a également admis avoir utilisé Veo 3 pour réaliser cette vidéo, inspirée d'une arnaque impliquant un deepfake d'Elon Musk.

La Corée du Sud renforce son contrôle : loi sur l’IA et failles

Face à la vague de deepfakes, la Corée du Sud a promulgué la « Loi fondamentale sur l’IA », qui entrera en vigueur en janvier 2026. Cette loi impose le marquage de toutes les vidéos réalisées par intelligence artificielle afin que les spectateurs puissent les identifier facilement. Cependant, des experts craignent que ces marquages puissent être facilement supprimés ou modifiés, réduisant ainsi l’effet dissuasif de cette mesure.

M. Choi Byung-ho, expert à l'Institut de recherche en intelligence artificielle de l'Université de Corée, a commenté : « Si les entreprises spécialisées en IA développent une technologie permettant d'identifier les faux contenus, cela réduira les coûts sociaux et sera plus efficace que les mesures administratives. »

Deepfake : du divertissement à la fraude et à la manipulation politique

Les deepfakes ne servent plus seulement au divertissement ou à la satire, mais deviennent des outils pour des activités illégales graves. Ils sont utilisés pour créer des contenus offensants sans consentement, pour des fraudes financières et même pour des manipulations politiques.

Lors des élections législatives de l'année dernière, l'agence électorale nationale sud-coréenne a détecté et traité plus de 120 images et vidéos truquées générées par intelligence artificielle. Cet incident a conduit à l'instauration d'une obligation de transparence stricte concernant l'utilisation de l'IA dans les campagnes électorales, afin de garantir la transparence et l'équité pour les électeurs.

Le développement rapide de la technologie deepfake exige des mesures de contrôle et d'identification plus efficaces pour protéger les personnes contre la désinformation et les escroqueries potentielles.