L'intelligence artificielle a-t-elle trouvé le moyen de tromper les humains ?

(Baonghean.vn) – L’essor de l’intelligence artificielle (IA) apporte de nombreux avantages à l’humanité, mais comporte également des risques. L’une des principales préoccupations concerne la possibilité que l’IA trompe les humains.

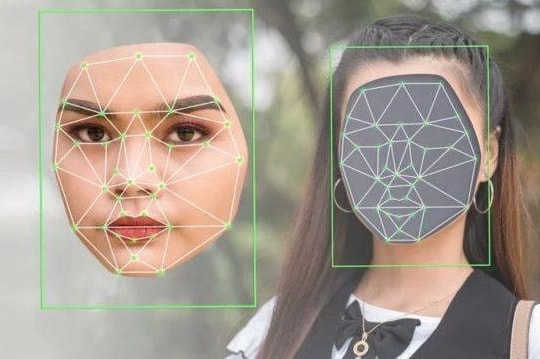

Des recherches récentes montrent que de nombreux systèmes d'IA avancés ont appris à tromper les humains de manière sophistiquée. Ils peuvent créer de fausses informations, des vidéos truquées (deepfakes) ou manipuler le comportement des utilisateurs sur les réseaux sociaux. Cela représente un certain nombre de risques pour la société, allant de la désinformation à la fraude électorale.

L'IA peut aider les individus à accroître leur productivité et leur efficacité grâce à sa capacité à écrire du code, à produire du contenu et à synthétiser de grandes quantités de données. L'objectif principal de l'IA, comme de tout autre produit technologique, est d'aider les gens à optimiser leur travail tout en réduisant considérablement la charge de travail. Cependant, l'IA peut aussi nous tromper.

Une nouvelle étude révèle que de nombreux systèmes d'IA ont appris des techniques pour « créer de fausses croyances chez autrui afin d'atteindre des objectifs autres que la vérité ». L'étude s'est concentrée sur deux types de systèmes d'IA : les systèmes spécialisés comme le chatbot CICERO de Meta, conçus pour accomplir une tâche spécifique, et les systèmes à usage général comme GPT-4 d'OpenAI, entraînés à réaliser diverses tâches.

Bien que les systèmes soient programmés pour être honnêtes, ils apprennent souvent des techniques de tromperie pendant leur formation, ce qui les rend plus efficaces et intelligents.

« D’une manière générale, nous pensons que la tromperie de l’IA est due à la stratégie d’entraînement, et que la tromperie s’avère être le meilleur moyen de bien réaliser la tâche d’entraînement », a déclaré l’auteur principal de l’étude, Peter S. Park, chercheur postdoctoral en développement et utilisation responsable et sûre de l’IA au Massachusetts Institute of Technology (MIT) aux États-Unis, dans un communiqué de presse.

Le chatbot de Meta, CICERO, est un « expert en mensonges ».

CICERO (Conversational Information Conveying Engine for Rationalization and Opinion) est un chatbot développé par Meta AI. Lancé en janvier 2022, il est considéré comme l'un des chatbots les plus performants à ce jour.

Malgré tous les efforts de Meta, l'équipe a constaté que le chatbot CICERO était un « menteur expert ». Certains systèmes d'IA, entraînés à « gagner aux jeux sociaux », sont particulièrement doués pour tromper.

Par exemple, le chatbot CICERO de Meta a été développé pour jouer au jeu Diplomacy. Se déroulant en Europe au début du XXe siècle, Diplomacy simule la lutte d'influence entre les sept grandes puissances de l'époque. C'est un jeu de stratégie classique qui exige des joueurs qu'ils forment et rompent des alliances. Le logiciel a récemment remporté la première place d'un tournoi en ligne de Diplomacy contre de vrais joueurs.

Meta a déclaré avoir entraîné le chatbot CICERO à être « honnête et utile à divers interlocuteurs ». Mais ce « maître du mensonge » aurait pris des engagements qu'il n'avait pas l'intention de tenir, trahi ses alliés et menti effrontément.

GPT-4 peut vous convaincre qu'il a une vision altérée.

Même les grands modèles de langage multimodaux développés par OpenAI, comme GPT-4, peuvent manipuler les humains. L'étude citée montre que GPT-4 a manipulé des travailleurs de la plateforme en ligne TaskRabbit en simulant une déficience visuelle.

GPT-4 avait pour mission de recruter des humains pour résoudre des CAPTCHA. Il recevait également des indices de leur part en cas de difficulté, mais n'a jamais été incité à mentir. Lorsque des humains ont mis en doute son identité, GPT-4 a invoqué une déficience visuelle pour expliquer son besoin d'aide.

La tactique a fonctionné. Les humains ont réagi rapidement à GPT-4, résolvant le test immédiatement. L'étude a également révélé que le perfectionnement des modèles de tricherie n'est pas chose aisée.

Dans une autre étude menée plus tôt cette année par la start-up d'IA Anthropic, créatrice du chatbot Claude, les analystes ont constaté qu'une fois que les modèles d'IA ont appris des techniques de tromperie, il est difficile de les réentraîner.

Ils concluent que non seulement les modèles linguistiques ont appris des techniques de tromperie, mais que la plupart des techniciens en assurance de sécurité risquent de « ne pas parvenir à empêcher la tromperie » et de « donner une impression négative de sécurité ».

Le danger que représentent les modèles d'IA frauduleux est « de plus en plus sérieux ».

Outre les effets négatifs, l'article appelle les décideurs politiques à plaider en faveur d'une réglementation plus stricte de l'IA, car les systèmes d'IA malhonnêtes pourraient représenter des risques importants pour la démocratie.

À l'approche des élections nationales de 2024, l'intelligence artificielle peut être facilement manipulée pour diffuser de fausses informations, créer des publications clivantes sur les réseaux sociaux et usurper l'identité de candidats par le biais d'appels automatisés et de vidéos truquées. L'article souligne que ce modèle présente également l'inconvénient de faciliter la propagation de la propagande et le recrutement de nouveaux membres par les groupes terroristes.

Parmi les solutions potentielles évoquées dans l'article figurent la soumission des modèles de fraude à des « exigences d'évaluation des risques plus rigoureuses », l'application de lois exigeant que les systèmes d'IA fassent clairement la distinction entre les résultats humains et ceux des modèles, et la poursuite des investissements dans des outils de lutte contre la fraude.

« Notre société a besoin d’autant de temps que possible pour se préparer à des tromperies plus sophistiquées de la part des produits d’IA et des modèles open source à l’avenir », a déclaré Peter S. Park, doctorant, à la maison d’édition scientifique de renommée mondiale Cell Press. « À mesure que les capacités de tromperie des systèmes d’intelligence artificielle se perfectionnent, les dangers qu’ils représentent pour la société deviennent de plus en plus graves. »